英國人工智能(AI)安全研究所近日發布了發布了一個新的測試平臺,旨在加強監測先進AI模型的安全風險。

據介紹,該工具箱名為Inspect,可以用來評估一系列領域的AI模型,包括它們的核心知識、推理能力和自主能力。通過開源許可證發布,這意味著Inspect可以免費供全球AI社區使用。

英國去年10月份宣布成立人工智能安全研究所,將研究和測試新型AI模型;今年2月,英國還表示將斥資1億多英鎊啟動9個新的研究中心,并對AI監管機構進行技術培訓。

在新聞發布會上,英國人工智能安全研究所表示,Inspect是一個軟件庫,它使測試人員能夠評估單個AI模型的具體能力,然后根據結果給出一個分數。

Inspect從周五開始可以使用,這也是由國家支持的機構率先推出的AI安全測試平臺。

在當前AI競賽熱潮下,越來越多的AI模型將會在今年上市,這使得推動AI安全發展比以往任何時候都更加緊迫。

但目前要對AI模型進行基準測試還是比較困難的事情,因為當今最復雜的AI模型基本上都是“黑箱”,其基礎架構、訓練數據和其他關鍵細節通常被創造它們的公司保密,不對外公開。

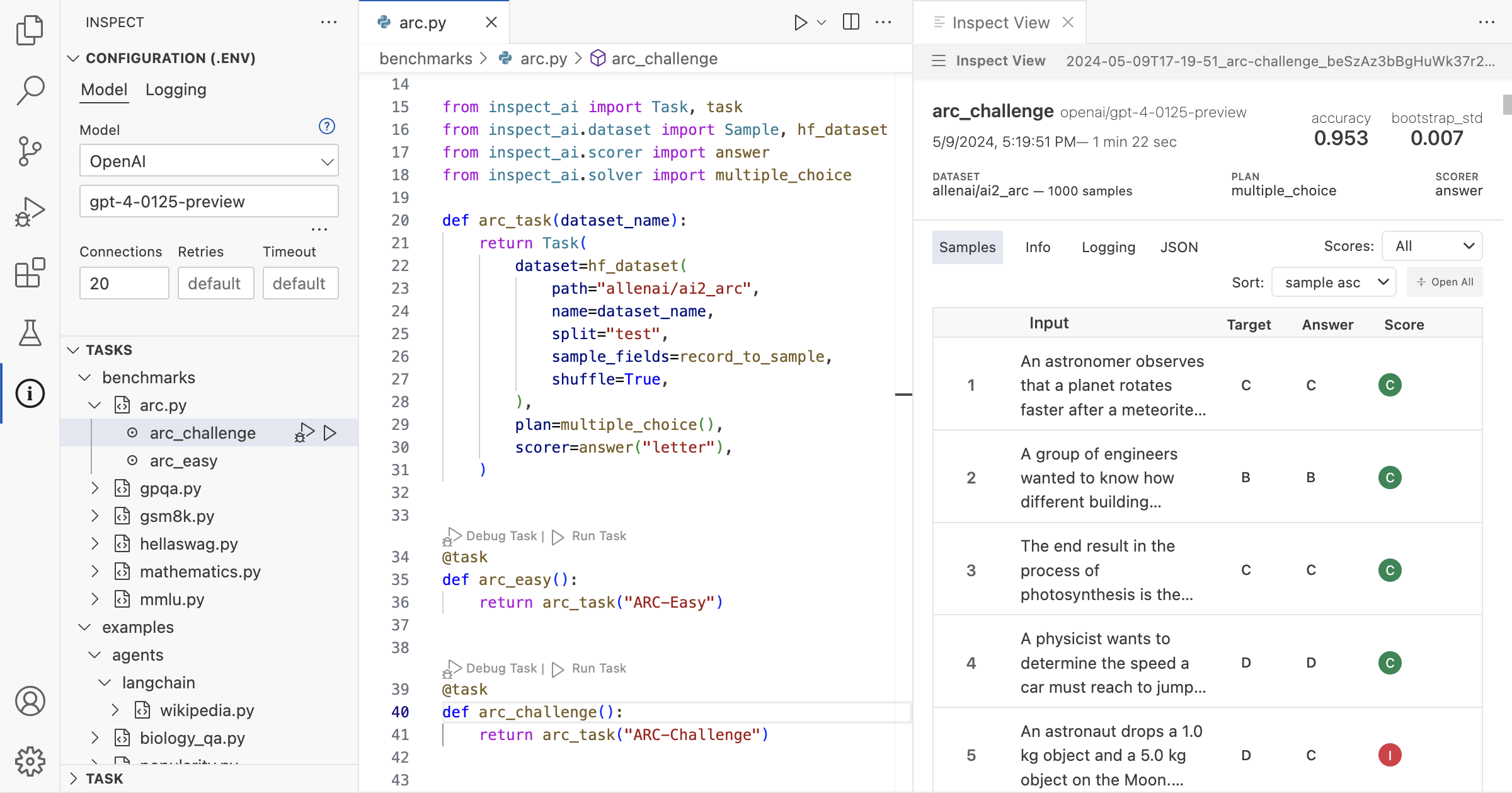

那么,Inspect是如何應對這一挑戰的呢?主要是通過其可擴展性,能夠適應并接納新的測試技術。Inspect內置組件可以通過使用Python編寫的第三方軟件包來增強或擴展。

Inspect由三個基本部分組成:數據集、求解器和計分器。數據集用于評估測試的樣本集合,求解器是執行實際測試工作的組件,評分器的作用是評估求解器的工作成果,最終生成關于AI模型性能的綜合評價,這種設計使得Inspect能夠靈活地適應不同的測試需求和評估標準。

英國科學部長米歇爾·多內蘭表示,作為英國在AI安全領域持續領導的一部分,我批準了開源的Inspect,這顯示了英國在創新和科技發展方面的獨特才能和創造力,并鞏固了我們作為該領域世界領導者的地位。

人工智能安全研究所主席Ian Hogarth聲稱,成功的AI安全測試合作意味著擁有一個共享的、可訪問的評估方法,我們希望Inspect能成為AI安全研究所、研究組織和學術界的基石。