10月29日消息,YouTube視頻博主 ServeTheHome 首次曝光了埃隆·馬斯克 (Elon Musk)旗下人工智能企業xAI的Colossus AI 超級計算機集群,其集成了100000個英偉達(NVIDIA)H100 GPU,號稱是目前全球最強大的AI超級計算機集群。

早在今年7月下旬,馬斯克就在“X”平臺上宣布,自己已經啟動了“世界上最強大的 AI 集群”。這座AI集群從開始建設到完成組裝僅花了122天就完成了,目前已經上線運行了約3個月。

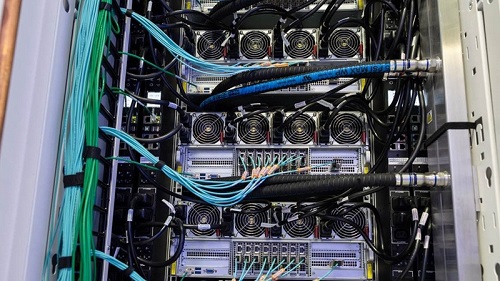

根據ServeTheHome曝光的信息來看,龐大的Colossus AI超級計算機集群采用的是超威電腦(Supermicro)的服務器,其基于NVIDIA HGX H100方案,每個服務器中擁有8個H100 GPU,封裝在 Supermicro 的 4U 通用 GPU 液冷系統內,為每個 GPU 提供簡單的熱插拔液冷。這些服務器裝載在機架內,每個機架可容納 8 臺服務器,也就是說每個機架內有 64 個 GPU。1U 歧管夾在每個 HGX H100 之間,提供服務器所需的液體冷卻。每個機架的底部是另一個 Supermicro 4U 單元,這次配備了冗余泵系統和機架監控系統。

△四組 xAI 的 HGX H100 服務器機架,每組可容納八臺服務器。(圖片來源:ServeTheHome)

△xAI Colossus GPU 服務器的后部訪問。每臺服務器有 9 根以太網電纜,每臺服務器有 4 個電源。電源和液體冷卻軟管也可見。(圖片來源:ServeTheHome)

這些機架以 8 個為一組配對,每個陣列有 512 個 GPU。每臺服務器都有四個冗余電源,GPU 機架的后部露出三相電源、以太網交換機和一個提供所有液體冷卻的機架大小的歧管。Colossus 集群中有超過 1500 個 GPU 機架,或近 200 個機架陣列。據英偉達首席執行官黃仁勛稱,這 200 個陣列的 GPU 僅用了三周時間就完成了安裝。

由于 AI 超級集群不斷訓練模型的高帶寬要求,xAI 在其網絡互連性方面提供了超大的帶寬。目前每個顯卡都有一個 400GbE 的專用 NIC(網絡接口控制器),每臺服務器還有一個額外的 400Gb NIC。這意味著每臺 HGX H100 服務器都有每秒 3.6 TB 的以太網速率。整個集群都在以太網上運行,而不是 InfiniBand 或其他在超級計算領域標配的連接。

△仰望一大片的黃色以太網電纜,將 xAI Colossus 集群連接在一起。多層過寬的電纜線路嵌入天花板中。(圖片來源:ServeTheHome)

△xAI 的 Colossus CPU 計算服務器,看起來與該站點中也廣泛使用的 Supermicro 存儲服務器完全相同。(圖片來源:ServeTheHome)

當然,像 xAI 旗下Grok 3 聊天機器人這樣基于訓練 AI 模型的超級計算機需要的不僅僅是 GPU 才能運行。Colossus集群當中的存儲和 CPU 計算機服務器的詳細信息仍未曝光,不過這些服務器也大多采用 Supermicro 機箱。一波又一波的 NVMe 轉發 1U 服務器內部帶有某種 x86 平臺 CPU,可容納存儲和 CPU 計算,還具有后入式液體冷卻功能。

另外,在該超級計算機集群的外面,還可以看到一些大量捆綁的特斯拉 Megapack 電池(每個最多可容納 3.9 MWh)。該電池陣列的是為了應對突發停電的臨時備用電源,其可以在毫秒之間快速提供供電,相比柴油發電機反應要快得多,可以使得有足夠時間去啟動其他備用電源。